Для начала новость, которая здесь уже обсуждалась - Задержка с 10-нм техпроцессом подорвала уверенность Apple в Intel

Ещё один крупный медийный источник выражает уверенность в намерениях Apple объявить в грядущий понедельник о переводе части персональных компьютеров семейства Mac на использование процессоров собственной разработки. Утверждается, что имидж Intel был подпорчен не только дефицитом процессоров, но и задержкой с переходом на 10 нм.

Соответствующую информацию вслед за Bloomberg опубликовало и издание The New York Times, ссылаясь сразу на пятерых людей, посвящённых в планы Apple. Компания, по их сведениям, несколько лет вела разработку собственных процессоров для применения в персональных компьютерах, и грядущую конференцию WWDC использует для соответствующего заявления.

Американское издание также сообщает со ссылкой на троих собеседников, что задержка Intel с переходом на 10-нм технологию производства процессоров послужила одним из толчков, усиливших уверенность Apple в необходимости отказаться от использования процессоров Intel в ряде изделий. Разразившийся позже дефицит процессоров Intel только укрепил это убеждение. Apple перестала рассматривать Intel в качестве надёжного партнёра.

Эпопея с задержками Intel по переходу на 10 нм технологию начинает напоминать сериал типа Престолов. Сам не смотрел, но народ фанатеет. Все ждут свержения Короля в лице Intel. Вот уже и яблочники грозятся свои ноутбуки перевести на процессоры собственной разработки. Еще раньше о разработке собственных процессоров говорили представители MicroSoft.

Во время карантина у друзей и родственников резко вырос спрос на апгрейд своей компьютерной техники. Пришлось вспомнить молодость и самому заняться этим делом. Тем более свободного времени стало больше. Заодно подросшее поколение надо поднатаскать. Возможностей конечно сейчас стало неизмеримо больше, чем во времена моей молодости. Сейчас есть Avito, AliEspress и прочие площадки, где можно найти и заказать что угодно, вплоть до давно вышедшей из серии экзотики.

Лишний раз на своем опыте убедился, насколько же притормозился рост производительности в компьютерной технике. Сейчас ноутбук 2011 года выпуска после небольшого апгрейда выполняет процентов 90 современных задач. Игрушки и прочее баловство в расчет не берем. Попробовал сравнить с тем что было на 20 лет раньше, компьютеры 1991 и 2000 года. В 1991-м типичной будет система на процессоре 486DX с частотой 25 МГц и до 1 Мб оперативки, в 2000-м компьютер на Pentium2 с частотой 400 МГц и 64 Мб опративки. Земля и небо, разные эпохи.

Причины такого замедления понятны, в прошлом году еще писал статью на эту тему - Технологии микроэлектроники на пальцах. «Закона Мура», маркетинговые ходы и почему нанометры нынче не те нанометры. Если вкратце, то кремниевые технологии достигли физических пределов. Раньше, когда в 2 раза уменьшалась технорма, то в 2 раза уменьшались все размеры транзисторов. Соответственно площадь каждого транзистора уменьшалась в 4 раза, примерно настолько же падало его энергопотребление. Можно было наращивать производительность без увеличения тепловыделения. Сейчас некоторые размеры транзисторов определяются не технормой, а физикой. Прежде всего длина канала МОП-транзисторов. Кроме того, по мере миниатюризации начало расти паразитное энергопотребление из-за токов утечки. Поэтому при уменьшении технормы с 14 нм до 7 нм линейные размеры транзисторов уменьшаются не в 2, а примерно в 1,2 раза. Соответственно площадь транзистора уменьшается не в 4 раза, а в 1,44 (условно). При этом из-за роста токов утечки энергопотребление каждого транзистора может вообще остаться тем же. Снижение паразитного энергопотребления это вообще отдельная тема, не связанная напрямую с нанометрами.

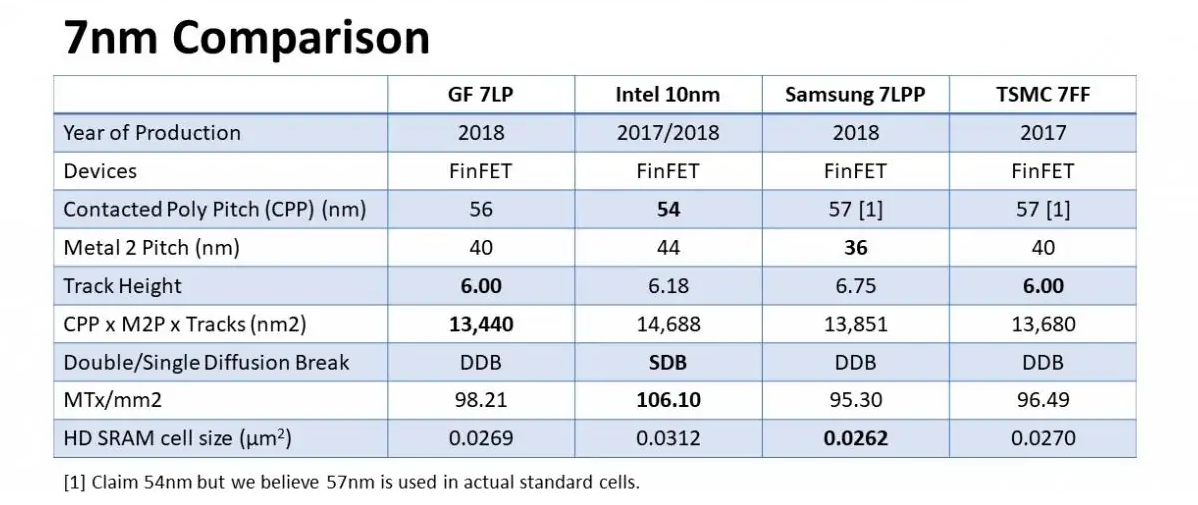

Картинка в подтверждение - характеристики технорм разных производителей

Смотрим на последнюю строку, это размер шеститранзисторной ячейки памяти. У Intel c технологией 10 нм он 0,0312 квадратных микрона, у Samsung'а с 7 нм технологией 0,0262 кв.микрона. Разница всего в 1,2 раза. При пропорциональном снижении размеров, как раньше, переход с 10 нм до 7 нм должен был дать уменьшение площади в 2 раза.

Если нет сокращения размеров транзисторов и снижения токов утечек, то невозможно увеличить производительность без увеличения тепловыделения. Сейчас часто приходится слышать о застое в производстве процессоров. На самом деле застоя нет, идет процесс оптимизации архитектуры, размеры транзисторов все-таки уменьшаются, сокращаются токи утечки, уменьшается время отклика. Просто скорость процесса не та, к которой пользователи привыкли за предыдущие десятилетия. Ничего, привыкнут.

Попробовал сделать свой прогноз на развитие отрасли с учетом кризиса. В смысле не экономического кризиса, а технологического.

Центральный процессор (CPU)

В производстве CPU долгое время доминировала фирма Intel. В 2011-м они выпустили прорывную на тот момент архитектуру Sandy Bridge. Новые процессоры не только на голову превосходили конкурентов, но и оказались дешевле. А единственным конкурентом Intel тогда была оставалась AMD. После этого AMD фактически была вынуждена покинуть рынок CPU. За прошедшее десятилетие монополии разработчики Intel неторопливо приглаживали свои процессоры, практически ежегодно выдавая на гора новую архитектуру, чуть улучшающую предыдущую. При этом то уменьшая на единицу количество ножек процессора, то увеличивая на 5. В названиях этих архитектур не запутались разве что фанаты. В 2017 раздавленный казалось бы AMD ворвался на рынок CPU с новой удачной архитектурой Ryzen. И с тех пор вернул себе значительную долю на рынке десктопов и ноутбуков. Монополия Intel пока остается только в нише серверных процессоров. Возвращение AMD внесло динамику в околокомпьютерное инфополе. Вновь вылезли фанаты красных (AMD), которые мочат фанатов синих (Intel) в бесконечных срачах на форумах. Как в старые добрые времена начала 2000-х.

Т.к. интенсивный рост производительности CPU затормозился, обе компании вынуждены идти по экстенсивному пути, наращивая энергопотребление процессоров. Первым следствием стало появление металлической крышки, которая припаивается к корпусу микросхем. Это улучшает отвод тепла от кристалла, из за чего температура ядра остается в пределах нормы, несмотря на увеличение тепловой мощности. Другим следствием стало увеличение допустимой рабочей температуры. Если раньше максимальная рабочая температура составляла 85˚С, то сейчас у многих в спецификации стоит 95˚С, а то и 100-105 градусов. Объясняют это тем, что старые процессоры не могли выдерживать такую температуру, а новые они же совершеннее, эти могут. В моду входят башни-кулеры для десктопов. Типа этого

Были попытки использовать и другие методы повышения производительности. Например на одной подложке с процессором встраивали кристалл динамической памяти в качестве кэша 4 уровня. Позднее от этой идеи отказались, но это решение может стать рабочим в скором времени.

Intel остается единственной компанией с собственным производством. Остальные переключились на контрактных производителей. Долгое время в производстве микроэлектроники под нормой техпроцесса понимали разрешение литографии. Когда начали сталкиваться с физическими ограничениями, в Intel пересмотрели методику вычисления технормы. Ее стали высчитывать исходя и площади транзисторов. Остальные производители идею не поддержали, продолжая указывать максимальное разрешение литографии в качестве нормы техпроцесса. Проблемы у Intel начались с переходом от 14 нм к 10 нм. Они хотели удивить мир и выдать честные 10 нм, чтобы плотность транзисторов была с 2 раза больше, чем в 14 нм. Кроме того, пользуясь тем, что никто в затылок не дышит, сконцентрировались на оптимизации технологии в плане снижения энергопотребления. В результате всего этого переход на 10 нм затянулся на 5 лет и обернулся маркетинговым проигрышем в гонке нанометров.

В самом Intel говорят о "проклятии 10 нм", обещают исправиться и уже в следующем году выйти на 7 нм. После этого ликвидируют отставание и вернут себе лидерство. Это можно расценивать как отказ от слюнтяйства и включение в общую гонку нанометров по формальному разрешению литографии.

Поэкспериментировав с различными конфигурациями, в Intel казалось бы пришли к единой идеологии - один кристалл на подложке, два потока на каждое ядро (гипертрейдинг) и выделение чипсета в отдельную микросхему. Однако в 2020-м Intel наконец выпустили давно анонсируемую серию процессоров для ноутбуков по технологии 10 нм. Новый процессор заставил напрячься, поскольку явно противоречит всей предыдущей идеологии. Процессор сделан слоями из нескольких разнородных чипов, еще и произведенных по разным технормам. Сам процессор реализован по схеме "все о одном", характерном для ARM-архитектуры. Содержит 5 однопоточных ядер - 4 малопотребляющих и 1 высокопроизводительное, - встроенную графику, все элементы чипсета и 8 Гб динамической памяти. И все это в одном корпусе. Пока не понятно что это - эксперимент или смена идеологии.

AMD в 2009 году выделил свое полупроводниковое производство в отдельную компанию GlobalFoundries.Таким образом, ADM оставили себе лишь разработку топологии процессора, все производство уходило в GlobalFoundries. Зажив своей жизнью, GlobalFoundries стал крупным контрактным производителем, купил несколько дочек за пределами США, в самих США выкупил часть заводов IBM, а в 2012-м продались инвестфонду из ОАЭ. В середине 2015-х ведущие производители микропроцессоров начали переход на объемные структуры FinFET, которые обеспечивали заметное улучшение энергетических характеристик. GlobalFoundries не смогли осилить переход на FinFET, а в 2018 отказались от борьбы за 7 нм. Компания некоторое время была в предбанкротном состоянии. Однако в конце 2019 продемонстрировали тестовую партию чипов по 12-нм FinFED, а в 2020 объявляют о готовности в следующем году вернуться в группу лидеров.

Тем не менее, с 2018 года производство процессоров AMD ушло на Тайвань. Сейчас они производятся на заводах TSMC по 7 нм техпроцессу. Кроме TSMC ведутся переговоры с корейским Samsung о переводе к ним части производства. Перевод производства в Восточную Азию положительно сказался на цене и технических характеристиках процессоров AMD. Появились даже оценки, что Intel стал катастрофически отставать от AMD. Они же в 10 нм никак не могут, а AMD в 7 нм смогло. В реале, как уже показывал, 10 нм от Intel имеют примерно те же характеристики, что и 7 нм от TSMC. А по энергоэффективности Intel даже опережает конкурентов.

Главной фишкой новых процессоров AMD стала быстрая универсальная шина Infinity Fabric, которая связывает ядра как внутри одного кристалла, так и на разных кристаллах. Сами ядра стали меньше и проще. По производительности они сильно уступают ядрам Intel, зато из-за дешевизны из можно пихать в процессор больше. В самых дорогих версиях до 64 ядер. AMD отошла от идеи единого кристалла и перешла к идеологии чиплетов, т.е. небольших модульных кристаллов. Вот так например

2 одинаковых модуля сверху содержат по 8 ядер и по 8 МБ кэша L3. На нижнем кристалле располагается встроенное видео, еще кэш L3 и контроллеры (памяти, шины PCI-e, USB и пр). Оперируя числом модулей, можно на одних и тех же чиплетах собрать линейку процессоров от самых дешевых до серверных монстров. Небольшой размер чиплета упрощает отвод тепла из кристалла и нивелирует меньшую энергоэффективность транзисторов. Также из-за меньших размеров чиплета обычно выше процент выхода годных кристаллов. Больше того, если например в 8-ядерном чиплете оказывается нерабочим одно или несколько ядер, они блокируются, а сам чиплет уходит на упаковку как 6-ти или 4-х ядерный. Это все сильно удешевляет себестоимость конечной сборки.

ARM процессоры. В 2017 году вышли первые ноутбуки с процессорами Qualcomm по архитектуре ARM. Инициатором этого выступила как ни странно компания Microsoft. Мелкомягкие в свое время полностью слили рынок мобильных устройств и на этот раз похоже решили действовать на опережение. Застолбить рынок компактных ноутбуков со встроенным LTE-модулем (4G). За 2,5 года Qualcomm и Microsoft успели уже выпустить второе и анонсировать третье поколение ARM процессоров для ультрабуков под операционной системой Windows 10 ARM. Были даже статьи, что новые ноутбуки обходят по производительности младшие версии x86 при вдвое меньшей тепловой мощности. Правда стандартные компьютерные тесты показали что это совсем не так. В чем новые ARM-ноутбуки выигрывают, так это в длительности автономной работы и в некоторых тестах с ПО от MicroSoft. В последнем случае, как полагают, причиной является более эффективное использование многоядерности и многопоточности процессоров. Т.е. речь идет о более оптимальном коде от мелкомягких, а не о производительности процессоров.

Не секрет, что операционки и программы тащат на себе груз совместимости со старым софтом и старыми средствами разработки. Поэтому код не оптимизирован под современные процессоры и не использует в полной мере их возможности. Это справедливо и для самой архитектуры x86, где остается много рудиментов. Поэтому новая ОС, написанная под конкретную архитектуру, не отягощенная совместимостью со старым софтом, сразу получает преимущество. Правда обратной стороной является ограниченный набор этого самого оптимизированного софта. С остальным необходимо работать через эмулятор со всеми вытекающими тормозами.

И вот наконец к дуэту Qualcomm и Microsoft присоединилась Apple. Пишут даже что яблочники уже заключили договор с TSMC и планируют во второй половине 2021 года заказать выпуск процессоров ARM собственной разработки. Ясно, что такое решение приняли не спонтанно, и задержки Intel в переходе на 10 нм это только повод.

Чипсет.

На рынке чипсетов для материнских плат те же основные участники - Intel и AMD. Каждый производит чипсеты с поддержкой своих процессоров. ARM-процессоры выполнены по принципу "Система-на-кристалле" (SoC), там все функции чипсета встроены в процессор. Кстати новые ноутбучные процессоры Intel сделаны по ой же идеологии. Intel и раньше выпускал SoC процессоры с низким энергопотреблением для ультрабуков (обычно маркировались буквой U). Т.е. технических проблем реализовать их на всех процессорных линейках нет. Вопрос тут идеологический. Чипсет как отдельная микросхема интересен прежде всего производителям материнских плат. Микросхема чипсета является ядром, вокруг которого собирается плата. Каждый чипсет поддерживает несколько серий процессоров, а под каждый процессор можно подобрать несколько чипсетов с разным набором поддерживаемой периферии. Это дает одновременно большую универсальность и широкий спектр конфигураций материнских плат.

Процесс миграции элементов чипсета под крышку CPU начался с первых модификаций микропроцессоров. За последнее время в процессор переместились, например, контроллер памяти, часть функций контроллера PCIe и USB. При сохранении тенденций чипсет как отдельное устройство может совсем исчезнуть, полностью интегрировавшись с CPU.

Видеопроцессоры (GPU)

Практически во всех современных процессорах есть встроенный GPU. Исключение составляют серверные процессоры. Тем не менее, дискретные видеопроцессоры по-прежнему востребованы, т.к. имеют кратно более высокую производительность. По сложности и числу транзисторов современные GPU не уступают CPU. Здесь также осталось всего 2 крупных производителя - nVidia и AMD. Как и на рынке центральных процессоров, AMD представляет более бюджетные версии по сравнению с лидером в лице nVidia. Оба производителя делят заказы своих микросхем примерно поровну между заводами TSMC и Samsung.

В эволюции видеопроцессоров видны те же тенденции, что и для центральных процессоров. Здесь они даже более выражены. Из-за того, что интенсивный рост производительности затормозился, производителям GPU приходится идти по экстенсивному пути. Поскольку разработчики компьютерных игр продолжают прежними темпами выдавать все больше требований к видеосистеме. Современная топовая видеокарта выглядит примерно так

Если серверный процессор с потреблением в 200-300 Ватт является предметом зубоскальства и сравнения с паяльником, то видеокарта мощностью в 300 Ватт давно считается нормой, как и предельная рабочая температура в 105˚С. На видеокарту приходится львиная доля энергопотребления в современных игровых системах. В отличии от CPU, для видеопроцессоров нет даже серьезного резерва в виде оптимизации архитектуры.

На видеокартах раньше, чем на материнских платах, отрабатываются более производительные архитектуры и механизмы работы с памятью. Графическая память обычно работает на более широкой шине данных, использует передачу 2 бит данных за такт, раздельное тактирование адресов и данных, удвоенную частоту шины передачи данных. В итоге эффективная тактовая частота для видеопамяти в 4 раза выше реальной. Например для GDDR5 c частотой 1500МГц эффективная частота составляет 6000МГц. В новых моделях видеокарт используется уже тип видеопамяти GDDR6, где пропускная способность выросла еще в 2 раза.

Оперативная память

Рост миниатюризации в микросхемах оперативной памяти затормозился еще раньше, чем в процессорах. Причина опять в физике. Современная оперативная память построена на микросхемах динамической памяти DRAM, где каждый транзистор является еще и микроконденсатором. А чем меньше площадь конденсатора, тем быстрее он теряет заряд и чаще требует перезарядки. Кроме того, при снижении технормы растут токи утечки, что еще больше сокращает время хранения.

В последнее десятилетие рост производительность оперативной памяти растет, в-основном, за счет увеличения разрядности шины, роста тактовых частот и плотности передаваемой за такт информации. А не за счет роста плотности упаковки транзисторных ячеек, как раньше.

Типовой сейчас является память стандарта DDR4 с эффективной частотой 3200 МГц. Это соответствует максимальной скорости чтения 25,6 ГБ/с на канал. Если у вас в процессоре 2-канальный контроллер памяти и 2 модуля памяти на материнке, то это уже 51,2 ГБ/с. Ну а если топовый или серверный 4-канальный процессор и 4 планки памяти, то до 102,4 ГБ/с. Давно анонсируется, но пока откладывается переход на DDR5, который ужа на первых сериях должен выдать пропускную способность в 32 ГБ/с.

Более 95% микросхем DRAM в мире выпускают 3 фирмы - Samsung (Ю.Корея), SK Hynix (Ю.Корея) и Micron Technology (США). Основной завод Micron по выпуску микросхем DRAM расположен в Японии, это бывший завод NEC. Почти 3/4 объема рынка приходит на 2 корейские фирмы. В 2020 году китайцы выпустили первые полностью суверенные модули памяти DDR4. Характеристики пока посредственные, но это первые модули на полностью китайских микросхемах DRAM.

Системы хранения данных

Системы хранения данных, их по привычке продолжают называть жесткими дисками, - эта область, где в последние годы достигнут самый явный прогресс. Связан с постепенной заменой магнитных дисков с механическим приводом (HDD) на твердотельные накопители на микросхемах РПЗУ (SSD).

В старые времена приходилось иногда проводить бессонные ночи за установкой или переустановкой какой-нибудь системы. Активный процесс занимал хорошо если 5% от всего времени. Остальное время приходилось медитировать под потрескивание жестких дисков. Как же я ненавидел этот звук под утро, когда пора было уже запускать отлаженную рабочую систему, а эта тмбня все никак не протарахтится. Когда первый раз воткнул в свой ноут SSD накопитель, понял, что возврата к механике уже не будет. Это настолько ускоряет процесс загрузки, открытия окон и приложений, что эффект пересиливает даже апгрейд памяти и процессора.

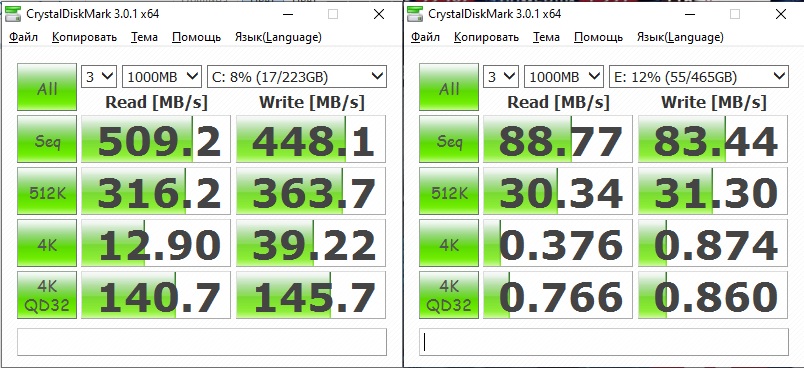

Массовый сегмент SSD накопителей сейчас переходит с объемов 120 ГБ к 240 ГБ. По цене за гигабайт они пока в 2-3 раза дороже HDD, но быстро дешевеют. По скоростям доступа небольшая картинка с тестом из моего ноутбука.

Смысл картинки. Слева скорости чтения и записи SSD накопителя Kinston SA400 емкостью 240 ГБ, справа HDD Toshiba емкостью 500 ГБ и скоростью вращения 5400 об/мин.

Первая строка - последовательное чтение большого нефрагментированного файла

Вторая строка - чтение крупных сегментов по 512 КБ

Третья строка - поштучное чтение случайно расположенных файлов размером 4 КБ, самый тяжелый тест

Четвертая строка - параллельное чтение случайных файлов размером 4 КБ с глубиной очереди 32. Наиболее близкий к работе операционной системы. Здесь считываются маленькие файлы, но контроллер знает список из 32 файлов. В случае HDD это мало чем может помочь, т.к. считывающая головка одна, максимум может оптимизировать маршрут перемещения. В случае SSD это позволяет распараллелить операции чтения/записи. В этом случае преимущества SSD раскрываются в полной мере, разница в скоростях более чем 100 раз.

Сейчас на рынке 2 основных типа накопителей - стандарта SATA-III и NVM-express. Первый работает через контроллер жестких дисков (SATA), второй через контроллер PCI-express, занимая 4 полосы PCIe. Скорость линейного чтения у SSD SATA-III, обычно около 500 МБ/с, у NVMe накопителей она достигает 2-3 ГБ/с, у самых быстрых HDD линейная скорость 120-150 МБ/с. Для сравнения оперативная память формата DDR3 c частотой 1333 МГц, все еще часто встречающаяся, выдает максимальную скорость чтения 10,6 ГБ/с. Т.е. разница с накопителями NVMe уже меньше чем на порядок.

SSD накопитель состоит из контроллера и микросхем NAND на МОП транзисторах с плавающим затвором или ловушкой заряда. Главный недостаток NAND технологии - деградация ячеек по мере работы. Чтобы компенсировать это, контроллер SSD резервирует четверть ячеек на замену выбывшим и организует специальный механизм записи, чтобы данные максимально распределялись по рабочим ячейкам. Т.е. SSD накопитель на 120 ГБ имеет реальный объем 160 ГБ, просто 40 ГБ зарезервированы контроллером и выделяются только по мере выработки ресурса рабочими.

Альтернативой является технология 3D XPoint от Intel и Micron. Детально информацию они не раскрывают, но известно что используются фазовые переходы в некоторых соединениях серы, селена и теллура. Упрощенно, если нагреть ячейку до 600 градусов и быстро охладить, то она переходит в аморфное состояние с высоким электрическим сопротивлением. А если еще раз нагреть до 700 градусов и охладить, то ячейка становится кристаллической с низким электрическим сопротивлением. Эти состояния определяются как логический 0 или логический 1. В Intel заявляют, что смогли сделать еще два промежуточных состояния, поэтому имеют возможность в одной ячейке хранить 2 бита информации. Главным достоинством технологии является слабая деградация по мере использования, на несколько порядков медленнее, чем у NAND. Можно сказать что ее нет совсем. А также более высокая скорость записи, т.к. в 3D XPoint ячейка сразу записывается в нужное состояние. В технологии NAND перед записью нужно обнулить текущее состояние ячейки. Недостаток - меньшая плотность ячеек и соответственно более высокая цена за гигабайт. Т.к. приходится размещать больше микросхем для получения тех же объемов.

На основе 3D XPoint Intel выпускает накопители Optane. Стоимость 120 ГБ Optane сейчас 17000 руб, в 10 раз больше чем у бюджетных SSD на 120 ГБ. Поэтому их обычно ставят в серверные системы, где цена не принципиальна. Чтобы выйти в бюджетный сегмент, в Intel придумали "гениальную" идею, начали выпускать дешевые Optane на 16 ГБ. Но т.к. для полноценной системы это сейчас мало, решили использовать его для кэширования HDD. Т.е. 16 ГБ Optane работает в связке с жестким диском, на нее записываются наиболее употребляемые файлы, и при работе с ними система обращается к Optane. А Optane уже в фоновом режиме обеспечивает запись на HDD. Лет 10 назад идея могла взлететь. Но сейчас, когда массово появились дешевые SSD накопители большой емкости ...

Еще более перспективной технологией представляется магниторезистивная память (MRAM). Пока у нее плотность упаковки даже ниже чем у 3D XPoint, но в последние годы появилось несколько перспективных разработок в области памяти MRAM. В случае с магниторезистивной памятью скорость записи и чтения на накопитель практически равна скорости оперативной памяти.

Рынок SSD пока не устаканился и на нем довольно много участников - десятки производителей конечных устройств, 8 крупных производителей контроллеров и 6 крупных производителей микросхем NAND-памяти. Более 99% рынка микросхем NAND-памяти занимают, в порядке сокращения доли рынка, - Samsung (Ю.Корея), Kioxia (дочка Toshiba, Япония), Western Digital (США), Micron Technology (США), Intel (США), SK Hynix (Ю.Корея). Основное производство NAND-микросхем Western Digital расположено в Японии.

Прогнозы.

Ну а теперь сами прогнозы. Самые большие изменения вызовет прогресс в системе хранения данных. В ближайшие 2-3 года цена за гигабайт в SSD накопителях сравняется с HDD, и последние начнут уходить в небытие. Какое-то время могут задержаться как хранилища архивов, а затем уйдут в музей в отдел со стриммерами на магнитной ленте, дискетами и зарезервированным местом для CD-приводов. Сама скорость SSD будет расти. На экспериментальных накопителях она уже превосходит 9 ГБ/с. Правда стандартная шина такую скорость не пропустит, их подключают через 16-канальный PCIe. Через который обычно подключается видеоадаптер. С увеличением скоростей разработчикам процессоров и чипсетов придется выделить отдельный контроллер для SSD.

Переход от HDD к SSD обнажит другую проблему. Современные ОС и ПО разрабатывались во времена механических жестких дисков. Тогда скорость обращения к файловой системе была в сотни и тысячи раз медленнее, чем к оперативной памяти. Отсюда и попытка максимум информации держать в оперативной памяти, это сильно ускоряет работу. В приходом быстрых SSD разница в скорости доступа между оперативкой и файловой системой нивелируется. Если даже скорости не сравняются, но будут одного порядка, то теряется смысл сегодняшней парадигмы - держать максимум данных в оперативной памяти. Выгоднее будет большую часть оперативных данных перенести во временные файлы на SSD. Сразу же падают требования к объему оперативной памяти.

Думаю оперативная память в современном виде совсем исчезнет и трансформируется в кэш 4-го (а может уже и 5-го) уровня и возможно уйдет под крышку процессора. В этом плане надо внимательнее приглядеться к последнему процессору Intel Lakefield. Состоит из 4 слоев.

Нижняя часть - кристалл с контроллерами. Выполнена по 22 нм технорме. Эта технорма сейчас позволяет делать наиболее энергоэффективные микросхемы.

Второй снизу - кристалл с 5 ядрами, видеоядром и кэшем. Выполнена по 10 нм технорме, даем максимальную плотность упаковки и быстродействие.

2 верхних слоя динамической памяти LPDDR4X, типичной для смартфонов, по 4 Гб в каждом слое.

Ядра делятся на 1 высокопроизводительное и 4 малопотребляющих. Связано с тем, что многие современные приложения умеют нагружать только 1 ядро. Поэтому его сделали максимально производительным, а остальные упрощенными для уменьшения энергопотребления. Принцип разделения ядер похоже останется и в будущем, Intel анонсировал новые десктопные процессоры с 8 ядрами и 12 потоками. Явно речь о 4 однопоточных и 4 двухпоточных. Так что архитектура Lakefield это скорее был пробный шар в будущее.

Полагаю что такие разнородные структуры со временем станут нормой. Т.к. разные элементы CPU имеют разные требования к скорости и энергоэффективности. Возможно Intel вслед за AMD перейдет к чиплетам. Чипсет скорее всего исчезнет как класс, вместо этого придут к какой-то универсализации выводов CPU.

Каких-то прорывов в области производительности CPU и GPU не ожидается. Будет соревнование архитектур и постепенная оптимизация и архитектуры, и технологии производства. Со временем пользователи привыкнут к "застою" и тема роста производительности во что бы то ни стало постепенно уляжется. Тем более что все больше вычислительных мощностей будет переноситься "в облака" и требования к производительности клиентских систем будут снижаться.

Ну и про квантовые компьютеры. Надо понимать, что квантовый процессор может работать только при температурах в районе абсолютного нуля, т.е. -273˚С. поэтому требует наличия мощной криогенной установки. Если даже они войдут в серию, то придут на смену современным суперкомпьютерам. В ноутбуках, десктопах и небольших серверных останутся прежние кремниевые процессоры.

Комментарии

Простейшая истина состоит в том, что никакие новые процессоры не нужны ни в бытовых, ни в офисных компах. А это был самый массовый рынок.

Не надо недооценивать гиков и геймеров. В 1980-е рынок персоналок поднялся на гиках.

Иди ты! А я-то думал, на каких-то чахлых корпорациях США. И то верно, у гиков-то деньжат побольше, чем у какой-то дряблой Женерал Моторз.

Я имел в виду первые гаражные поделки, типа сборки Джобса и Возняка. Корпорации тогда пользовались большими мейнфреймами, а персоналки рассматривали как игрушки.

массовый рынок появился через корпоративный

иначе клиенты бы просто снесли Джобсу и Возняку гараж с таким спросом как сегодня

сначала компы стоили просто конских денег и это было вплоть до конца 90-х - позволить мог себе только бизнес

рынок фактически начался с удешевления и массового производства косячных процессоров Pentium

это конец 90-х начало 2000-х - как-то так

Я бы сказал, до середины 90-х. Когда появились многочисленные клоны 386-го и 486-го.

в сша да у нас немного позже

потому что выложить 1500-2000 долларов и выше за комп домой не каждый мог в России в 90-х

я смог купить себе первый комп домой и то б/у и за 700 баксов только в 1999 году!!! и это было событие реально...

Это да. Но именно рынок США и определял тогда направление и скорость развития.

Свой первый домашний 286-й в 1993-м за 650 прекрасно помню.

в 1993 году 286-й процессор это уже б/у дрова (анонсирован в 1982 году) - за 650 верю

в этом же 1993 году уже 4 года как актуальны 486-е (386-е на втором плане - первый выпуск 1985 года)

я это время хорошо помню - потому что в 1996 году как раз начал будучи еще студентом работать в компьютерной компании - торговали компьютерами Tulip (Голандия) заводской сборки - другие не признавали и прайс примерно еще помню тех лет - даже 386-е нам уже практически не отгружали - только 486-е

за 386-ми приходилось ездить в соседнюю Литву - там был крупный склад в Вильнюсе

На работе 486-е - это да. А дома мог себе позволить только 286-ю. Жесткий диск 20 Мбт, уж не помню как расшареный до 40. Как и хватало сейчас не понятно :)

ну где-то так, но всё-таки во второй половине 90х. р166ммх/32мб/s3virge4mb/винт не помню - чумовое месилово было с винтами по объёму, 1997 год, денег тоже не помню, но меньше 1к$.

Я бы не стал ставить на DRAM и SRAM, скорее MRAM на ансамблях упорядоченных квантовых магнитных точек. Высокая температурная стойкость, свыше 700К для некоторых материалов, не кремния. Выше защищённость ЗНАЧИТЕЛЬНО менее энергозатратна в т.ч. сравнима по записи и НОЛЬ при хранении, долгое хранение.

Если по больших объёмам безусловно голографическая ассоциативная память с произвольной выборкой. Вам достаточно предъявить условно кусочек изображения из фильма чтобы получить его весь Скорость ограничена только электронной частью - оптика допускает недостижимые для ЛЮБОЙ электронике даже трёхмерной не говоря о планарной скорость выборки и огромную скорость чтения - до больших терабайт в долю наносекунды. Переварить ЛЮБАЯ электронная система это не сможет.

То же самое по нейросетям высокой производительности, в частности импульсных с теми же гедонистическими. Оптика может проводить, если знаете как, я знаю, обучение весьма быстро - уже сейчас на допотопном лазерном железе достижимо время цикла обучения до 100фс для простейших подсистем и менее 10нс для основных. Годится более-менее для периферии для нормальных вычислителей, на свойствах пространства или как у вас писать любят на свойствах (конкретно флуктуациях) физического вакуума в смысле Дирака. Можно иметь чере лет 7 первые устройства и приступить к первым на оном принципе разработке вычислителей - перескочить через поколение оптических вычислителей можно но достаточно рискованно.

Зачем роям дронов большие терабайты в доли наносекунды?

В первую очередь не для дронов. Существуют и другие задачи.

Если для них разве для быстрого анализа. Оптоэлектронные процессоры с FFT были ещё на Проулерах лет 20 назад. Вероятно для анализа ЭМ спектра - самолёт РЭБ.

Статьи в "Квантовой электронике" года 1995 с фото чипа я давал, статьи см., есть и другие источники.

При такой производительности дронам вообще в рое ненужно иметь видеокамер. Есть несколько других способов. Т.к. нет смысла помогать противнику см. мои статьи с упоминанием Джеффри Кролика.

1нс это 300мм почти в вакууме и много меньше если полупроводники некоторые. Плотность потока оптической информации для волновой и некоторых иных видов записи может быть куда больше чем у обычных транспарантов для оптических вычислений.

Вообще-то товарищ Эйнштейн утверждал, что скорость распространения электро-магнитной волны в среде, равно как электрического тока в проводнике, да и любого взаимодействия, связанного с передачей информации, не превышает с = 300 тыс.км/сек. До сих пор этого никто не опроверг ни практически, ни в теориии.

Так что или у вас носители и способы передачи информации на иных физических принципах, или у вас глюки. Терабайты, наносекунды - вы порядки перемножьте, а то Альберт-то, наш, Эйнштейн уже в гробу вертится. Вместе с Эддингтоном. Они, так-то в шоке.

Терабайт = 8× 10¹² бит

Нано = 10-⁹, доля нано × 0.1 = 10-¹⁰

Имеем 8× 10²² бит/с

Согласно частоты найквиста 2х (даже без учета компрессии данных) 16× 10²² гц

Вполне таки гамма-излучение. Никаких противоречий с конечной скоростью света нет.

Как модулировать такое излучение, вопрос другой. Но человек выше ничего в разрез науки не сказал.

Исходный посыл был не про частоту, а про скорость чтения.

В ваших выкладках вы правы, я тут ничего не скажу. Но в принципе, понимая, что переход из 0 в 1 и из 1 в 0 - это конечный процесс, можно кстати, посчитать в принципе предельную скорость передачи данных по серийной линии.

Скорость чтения может быть любая. Для пример, возьмите плоский кристал, где каждый атом в решетке несет 1 бит информации. Пусть данный кристал будет размером 1х1 метр. Облучите его когерентным светом, тогда каждый атом переизлучит в зависимости от типа или состояния. И мы получаем, формально! считывание информации в огромных цифрах. Понятно что это абстракция, но мы не нарушаем физику и такая система возможна реальности и она не противоречит Эйнштейну

mram старая тема, но с параллельным доступом как-то не движется, всё как в 90-е - "сдвиговый" регистр памяти, а она в свою очередь с магнитными доменами.

давно про нее не было слышно, но как-бы лет 5 назад купил для поделок FeRAM последовательный для микроконтроллеров, но пока где-то лежит, не дошли тогда руки.

Массовый рынок появился после выхода IBM PC/XT. До того момента персоналки были в основном гаражными поделками для гиков.

Вотвот. И предназначалось это изделие вовсе не для геймеров, почему-то.

Верно, так как для тогдашних геймеров были поделки от других безвременно выбывших участников «регаты» (например, Atari, Commodore, Tandy и даже Sinclair).

А какая была 32 битная амига. Графическая операционка, 8 битная графика. Полноценый звук, 3д графика с редакторами, один только lightwave чего стоил.

Тогда было два названия интеллектуальный терминал и персональный компьютер.

Рулил выбором ИБМ, и победил маркетинг - персональных компьютеров продали больше.

Про интеллектуальный терминал все забыли.

вы просто застали эту часть революции в уже оформленном виде. А в США длительное время IBM PC считалась куском шустрого, но бесполезного дерьма. Вон она сверху, красавица, моя списаная, без HDD, без графического адаптера (голимый MDA) два флопа на 180 кб. И монитор с шикарным бирюзовым цветом (на фото перевран) и дичайшим послесвечением, так боролись с мельтешащей 30 Гц развёрткой.

Статью, что ли написать?

На "гиках" может подняться только новый рынок, где стоимость разработки относительно невелика, и прогресс идет быстро. Как, например, сейчас VR поднимается . А если новую разработку даже уже действующий миллиардный рынок с трудом финансирует, тысяча гиков погоды не сделает.

//Как, например, сейчас VR поднимается.

Лет 15 уже подымается, никак не подымется, и никакие виагры не помогают.

Интересно, на каком основании сделаны такие странные выводы? Чего VR не хватает, чтобы Вы соизволили его посчитать "поднятым"?

Наверное, объёмов продаж.

За 5 лет рынок вырос в 20 раз. Шлемы Valve Index предзаказаны на месяцы вперед, хотя они стоят за штуку баксов. Спрос сильно опережает предложение.

VR клубы есть почти в каждом ТЦ (это как компьютерные клубы в 2000-х для тех, кто не может себе позволить купить личный шлем). Игр, адаптированных под VR - полно. Игр специально под VR еще не так много, но тоже есть из чего выбрать, прошли времена, когда основные продажи делались одним Битсейбром.

// За 5 лет рынок вырос в 20 раз

А в абсолютных цифрах как не было его видно, так и сейчас не видно.

// VR клубы есть почти в каждом ТЦ

Вот я и говорю. Нету массового рынка и, думается, не будет никогда. То же самое, что случилось со стерео-телевизорами: оказались нахрен никому не нужны, за исключением 0,1% фанатов.

Сколько Вам надо в "абсолютных цифрах". чтобы увидеть?

Меткое замечание, компьютерные клубы в 2000-х тоже массово открывались, а потом все позакрывались, видать от того,что компы нахрен никому не нужны, кроме 0,1% фанатов.

Мне не надо, надо венчурным капиталистам.

// видать от того,что компы нахрен никому не нужны

С чего, вдруг, VR обязано пойти по той же траектории? Хрена с два. Никаким корпорациям VR не упёрлась, поэтому никакого удешевления и никакой массовости не будет.

то есть вы нихрена не знаете, и даже оценить не можете, но делаете утверждения? Ясно понятно...

ага, миллиарды вкладывают, но это не означает что им это надо...логично, ага

// миллиарды вкладывают, но это не означает что им это надо...логично

Говорят, в Биткоэн вложили сотни миллиардов. А вышло-то вот как...

ну во первых кто вкладывал вначале в итоге озолотились, так что не понимаю плача по ним)))

А во вторых таки предвиденьем будущего вроде никто не обладает, не так ли?

Ну и в третьих.....причем тут биткоины?)) VR это расширение/дополнение к существующему рынку. И помрет он только непосредственно с этим самым рынком. А игровой рынок помирать и не думает

// Ну и в третьих.....причем тут биткоины?)

А при том же,сколько вкладывается и сколько на выхлопе.

// VR это расширение/дополнение к существующему рынку.

Который стагнирует, а, местами схлопывается.

и с чего вы это взяли? Вы же сами сказали что нихрена о рынке не знаете?

На фоне пандемии игровой рынок один из немногих, который показал приличный рост.

Венчурные уже вложились в 2016-ом, сейчас они прибыли считают. Из крупных корпораций VR занимаются Сони, Самсунг, HTC, Фейсбук, Valve - это те, что уже выпускают массовый продукт. Есть еще несколько помельче типа Pimax. Про Гугл не говорю - они пока что в прототипах сидят. Цены на шлемы держатся в диапазоне от 500 до 1000$ - это сравнимо со стоимостью игрового компьютера. Кто может себе такой позволить, тот и шлем себе может купить. Ну а кому надо дешево и сердито - могут купить VR-шлем для смартфона за 1000 рублей.

// VR занимаются

Разговор не о том, кто "занимается", а кто это всё покупает.

// могут купить VR-шлем для смартфона

Могут, наверное, да чото не особо хотят.

Покупают пользователи. Да так, что все новинки на квартал вперед уже все выкупили.

А в салонах связи их, видать, для красоты держат, а не потому что их покупают. Там любят всякие непродающиеся штуки держать.

Сейчас глянул на Яндекс-маркет, этих шлемов для смартфонов уже сотня разновидностей в продаже от 300 рублей. Наверное от того, что не покупают их столько навезли.

Видать. Помнится, там и вертолётики валялись тоннами, но чото не вижу огромного количества пользователей вертолётиков, спустя 5 лет.

То есть, вы сейчас и про дроны будете рассказывать, как они никому не нужны, и как корпорации в них не вкладываются?

Поддержу камрада pokos – нету для летающих дронов нормально применения, акромя как подглядывать за кем-то. Остальные применения будут рано или поздно зарегулированы и отняты из влажных рук мечтающих гиков. И про шлемы VR тоже верно pokos написал. Если бы они были такие полезные, то появились бы в каждом доме и в каждой семье. А так это как 3D-телеки или как всеми забытые уже пейджеры, или джойстики вместо руля в электромобилях (джойстики только в самолётах со временем прижились).

Ну что же, наконец я дождался хоть какого-то внятного определения востребованности технологии: если ее нет в КАЖДОМ доме ПРЯМО СЕЙЧАС, то она никому не нужна и скоро загнется. Весьма интересно.

Изначальная идея, может, и не загнётся, если вдруг появится решение какого-то блокирующего фактора. Если еще не читали, то рекомендую прочитать книженцию «Дилемма инноватора. Как из-за новых технологий погибают сильные компании» (К. Кристенсен). Там на нескольких примерах разобраны основные проблемы инноваций.

Я тут накатал простынь текста, а потом понял, что мы просто говорим о разных вещах. VR вовсе не претендует на то, чтобы стать заменой смартфону и оказаться на каждой голове. То есть Вы абсолютно правы, он не станет в Вашем понимании "массовой" технологией точно так же, как не стали "массовыми" технологиями игровые приставки, игровые компьютеры, игровые рули, джойстики и прочие игровые приспособления. Их не было, нет и не будет в каждом доме хотя бы потому что не все играют в игры, а из тех, кто играет, не все играют в подходящие для VR жанры. Для экономической стратегии, например, VR не нужен, и какие-нибудь визуальные новеллы тоже могут обойтись.

Но для своей игровой ниши VR уже стал востребованной технологией. В современном шлеме реально удобно. 8 - часовые сессии с перерывом на туалет - запросто. Конечно, не все могут провести 8 часов на ногах но можно переключиться в режим "сидя" и продолжить игру. В VR игрок действительно погружается в игру, а не так как в плоских играх - смотришь на мир через окошко. Людям на самом деле интереснее самим что-то делать внутри игры, а не лениво тыкать мышкой, наблюдая за происходящим на экране. Half Life Alyx продано более миллиона копий в Стиме - это значит что уже сейчас у людей на руках более миллиона топовых шлемов, притом что более-менее нормальные шлемы появились года 3 назад только. Это, конечно, не миллиарды смартфонов, но тоже приличная армия. Я наблюдал людей, впервые надевших шлем - их это реально впечатляло. Не всех, конечно, но половину - точно.

Камрад, согласен, что мы немного с разных сторон смотрим на обсуждаемый вопрос. Но, кстати, только что Google выпилила свое подразделение, которое работало в области виртуальной реальности для конечных пользователей.

И не только Google. Поговаривают, что и Xiaomi тоже.

Страницы