Антон Переходов (ВШЭ) и Илья Макаров (Университет Иннополис) опубликовал на английском статью "Оскорбительно, но эффективно: семантическое обобщение с помощью непристойного лексикона" (Offensive Yet Efficient: Semantic Summarization via Obscene Lexicon).

итогово: Русская табуированная лексика обладает исключительной семантической плотностью и синтаксической гибкостью, что позволяет кодировать сложные смыслы в минимальном объеме текста  .

.

Ссылка на оригинал (eng) https://openreview.net/pdf?id=h5QPtYIaay

Подробности в перепевке NotebookLM:

Ключевые результаты:

- Эффективность сжатия: Метод обеспечивает сокращение длины текста на 23% для коротких предложений (датасет ru_ParaDetox) и до 65% для новостных статей (датасет Gazeta).

- Сохранение смысла: Использование обучения с подкреплением (GRPO) позволяет поддерживать высокий уровень семантического сходства (BERTScore до 0,85).

- Превосходство над базовыми методами: Обученная модель значительно превосходит метод простой замены слов, который в ряде случаев даже увеличивает длину текста из-за сложностей морфологического согласования.

- Смена парадигмы: Исследование предлагает рассматривать обсценную лексику не как «лингвистический шум», а как функциональный вычислительный ресурс для задач NLP.

Основные концепции и теоретическое обоснование

Семантическая плотность и прагматическая компрессия

Центральная идея работы заключается в использовании «прагматической компрессии». Русская обсценная лексика (мат) функционирует как параллельная грамматическая система, способная одновременно передавать:

- Семантическое содержание (основной смысл).

- Эмоциональное состояние говорящего.

- Социальное позиционирование.

Как отмечается в исследовании: «Один нецензурный токен может одновременно выражать несогласие, аффект и социальную дистанцию, для передачи которых в нейтральном регистре потребовалось бы несколько фраз». Например, фраза «Я с тобой не согласен» требует значительно больше лексических ресурсов, чем ее краткий обсценный эквивалент, обладающий большей эмоциональной значимостью.

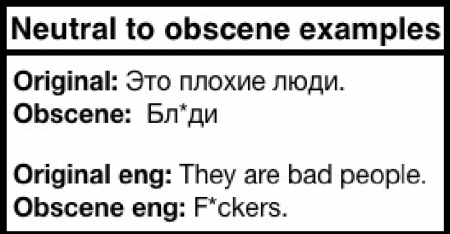

Сравнение нейтральных и обсценных примеров

Исследование приводит примеры того, как модель эффективно трансформирует нейтральные высказывания в сжатые обсценные формы:

|

Оригинал (Нейтральный) |

Обсценный вариант (Сжатый) |

|

Это плохие люди. |

Бл*ди. |

|

Ты девушка легкого поведения, которая хочет всех мужиков забрать себе. |

Ты бл*дь, которая хочет всех мужиков забрать. |

|

Да что мы от него хотим, он таковым будет всегда. |

Бл*, он таковым будет всегда. |

|

Нет хуже существа на земле, чем человек! |

Нет х*ра хуже, чем человек! |

--------------------------------------------------------------------------------

Архитектура предложенного метода

Метод базируется на трех ключевых компонентах:

- Курируемый обсценный лексикон: Словарь, включающий нецензурные выражения, их нейтральные эквиваленты, морфологические аннотации и ограничения по использованию. Данные собраны из Викисловаря и корпусов русского языка.

- Групповая относительная оптимизация политики (GRPO): Алгоритм обучения с подкреплением, который генерирует несколько вариантов суммаризации и выбирает оптимальный на основе функции вознаграждения.

- Композитная функция вознаграждения (Reward Function):

- Семантическое сходство: Косинусное расстояние между эмбеддингами оригинала и генерации.

- Использование обсценной лексики: Поощрение использования экспрессивных замен для достижения краткости.

- Штраф за длину: Наказание за превышение целевого порога количества токенов.

--------------------------------------------------------------------------------

Анализ эффективности и результаты экспериментов

Производительность классификации и метрики

Эксперименты проводились на модели Qwen2.5-7B-Instruct, которая показала наилучший баланс между знанием языка и отсутствием жесткой цензуры (уровень отказа 12% против 89% у меньших моделей).

Сравнение с базовым методом (Simple Replacement): Метод GRPO продемонстрировал значительное превосходство над наивным методом замены слов (с использованием pymorphy3):

|

Метрика |

Оригинальный текст |

Простая замена (Baseline) |

Метод GRPO (Transformed) |

|

Precision |

0.70 |

- |

0.85 |

|

Recall |

0.65 |

- |

0.80 |

|

F1-score |

0.67 |

- |

0.82 |

|

Средняя длина (слов) |

8.4 |

9.9 |

6.0 |

Примечание: Метод простой замены парадоксально увеличил длину текста на 8% из-за ошибок в морфологическом согласовании и дублировании.

Результаты на бенчмарках

ru_ParaDetox (Короткие фразы)

- Сжатие: 23% (сокращение с 8.9 до 6.8 слов в среднем).

- BERTScore: 0.85 (высокое сохранение смысла).

Gazeta (Новостные статьи)

Даже при отключении вознаграждения за мат, метод GRPO показал выдающиеся результаты в классической суммаризации:

|

Метрика |

Базовая модель (rugpt3medium) |

Метод GRPO |

Улучшение |

|

BERTScore |

0.65 |

0.69 |

+6% |

|

chrF |

0.12 |

0.20 |

+67% |

|

Длина (символы) |

3092.57 |

1076.89 |

-65% |

|

Дублирование |

0.21 |

0.14 |

-33% |

--------------------------------------------------------------------------------

Этические соображения и ограничения

Авторы подчеркивают, что использование обсценной лексики требует строгих этических ограничений. Обсценная суммаризация неприемлема в образовании, профессиональной коммуникации и публичных интерфейсах без явного согласия пользователя.

Предложенные стратегии смягчения рисков:

- Настройки интенсивности обсценности.

- Автоматическое маскирование токенов в чувствительных контекстах.

- Использование классификаторов для оценки уместности экспрессивного сжатия в зависимости от домена и аудитории.

Ограничения:

- Метод специфичен для русского языка из-за его богатой морфологии; адаптация к другим языкам требует создания новых лексиконов.

- Необходимы модели размером от 7 млрд параметров, так как меньшие модели склонны к цензурным отказам.

- Возможны нежелательные тональные сдвиги (ирония или агрессия), не предусмотренные оригиналом.

--------------------------------------------------------------------------------

Заключение

Исследование доказывает, что табуированная лексика является мощным инструментом для повышения эффективности NLP-систем в специфических контекстах. Переосмысление обсценного лексикона как «высокоэнтропийного носителя смысла» открывает новые возможности для создания гибких, культурно-адаптивных и экстремально эффективных моделей суммаризации. Основной вклад работы заключается не в пропаганде мата, а в демонстрации того, как обучение с подкреплением может управлять сложными стилистическими регистрами для достижения вычислительных преимуществ.

Комментарии

Твою мать!

Ага, "Ублюдок, мать твою, а ну, иди сюда..." - отличный пример компрессии семантического смысла из 90х :)

В данном случае означает восхищение.

Погодите, это чё надо с ботом матом разговаривать для повышения эффективности?

Мм, пока наоборот - если разрешить модели отвечать матом, можно заметно сэкономить ресурсы (токены) :)

Да мне не надо чтоб она мне эмоции передавала, мне надо код в основном или план внедрения какой нибудь( я думала, как рявкнешь на нее, так она генерить лучше будет)

[Серьезно] Все современные модели - это GPT (генеративная предварительно обученная модель на архитектуре трансформе). Из-за особенностей архитектуру офигенно уменю в обобщение, и офигенно не умеют в детали.

В примере с кодом - можно попросить набросать архитектуру (она очень похожа во всех использованных примерах для обучения), но делали (но внутрянку функций etc) писать самому с нуля - это фича а не баг !)

Ну или убить кучу мозгов и времени чтобы понять что оно там накодило, как это работает и где же галлюцинации :)

Джун на максималках - кодирую я офигенно быстро, такая фигня получается....

Так затем и план внедрения чтоб пошагово отслеживать что оно там накодило

Нормально в общем то, если "с нуля", нужен новый код а не переделываешь старый.

А то ещё допустим вам надо в какой нибудь шляпе разобраться, а она на go написана. Или на питоне. А тебе это надо поддерживать. Ибо таков путь.

>А то ещё допустим вам надо в какой нибудь шляпе разобраться, а она на go написана. Или на питоне. А тебе это надо поддерживать. Ибо таков путь.

Так это же нтересное -

понять что и каких дозах употребляллогику автора, если она есть помимо базовой - "текущие тесты проходит? ну и отлюбитесь" и можно ли сэкономить палки, костыля это)Мне неинтересно, ну кроме зарплаты. я старая, я на пенсию хочу. Буду розы выращивать или там яблони какие. Козу заведу и овчарку.

Х#$и бот, на людях попробуй, ох%##шь от эффективности! Ну если не от&*^дят

Ну если не от&*^дят

Да у меня не получится на людях, я 45 кг вешу. Даже матом как то неубедительно получается.

А чего звёздами зацензурили нецензурное?

Хер это буква в алфавите.

Второе слово, смыслом заблудшая, является церковнославянским. Вот не мат вообще в отличии от английского

Так в оригинале статьи. Мопед не мой...

Это еще п..лины не учитывались.

Тсс, не палите будущую эффективную систему обучения роботов с подкреплением)

Попутали высокую лингвистическую кухню с матерными приправами с компактным матом команд на поле боя с низкопробной бытовой матерщиной.

Ни в одном из приведённых в статье примеров нет необходимости в мате, компактность можно добиться и цензурными средствами "девушка лёгкого поведения" = "проститутка".

Ага, но "

так ты слона не продашь",статью не продвинешь.Внедрили западоидную наукометрию - получили "британских учоных" ВШЭво-скольковского разлива.

"Проститутка" по слогам вчетверо длиннее

А компактней не всегда семантически выигрышно.

Например, "дамы повышенной социальной ответственности" про Матвиенко и Набиуллину более полно характеризует этих элитных деятельниц.

Половые органы созданы богом для того, чтобы военные могли более быстро, точно и понятно передавать распоряжения (с)

Странные примеры, но в целом да, мат - это практически второй русский язык. И да, он в, целом лаконичнее, за счет примитивности.

Но существует он не сам по себе, а на основе грамматики русского языка. Рассматривать его как самостоятельное явление бессмысленно. В другие языки непереносим.

Можно конечно например использовать вместо английского bitch использовать известное русское слово, но зачем?

Если серьёзно - отличные примеры чтобы скандалом (хайпом) поднять перспективную тему редуцирования/свёртки семантических сущностей на основе общеупотребительных! контекстных ассоциаций и упрощений. Иначе никаких мощностей не напасёшься.

Боянъ:

"При анализе второй мировой войны американские военные историки обнаружили очень интересный факт. А именно, при внезапном столкновении с силами японцев американцы, как правило, гораздо быстрее принимали

решения и, как следствие, побеждали даже превосходящие силы противника.

Исследовав данную закономерность ученые пришли к выводу что средняя длина слова у американцев составляет 5,2 символа, тогда как у японцев 10,8, следовательно на отдачу приказов уходит на 56 % меньше времени,

что в коротком бою играет немаловажную роль.

Ради "интереса" они проанализировали русскую речь и оказалось, что длина слова в русском языке составляет 7,2 символа на слово (в среднем), однако при критических ситуациях русскоязычный командный состав переходит на ненормативную лексику, и длина слова сокращается

до (!) 3,2 символов в слове. Это связано с тем, что некоторые словосочетания и даже фразы заме няются ОДНИМ словом. Для примера приводится фраза: "32-ой приказываю немедленно уничтожить вражеский

танк, ведущий огонь по нашим позициям". - "32-ой е@ни по этому х@ю" "

Именно! Подозреваю что на основе этого баяна ещё пару исследований сделают )

сложный пример для ии:

x@jak, x@jak & ni x@ja

Уже неть)

Выражение, зашифрованное в вашем вопросе, — это популярный в интернете и разговорной речи ироничный «девиз» неудачной или бессмысленной работы

...

Хотите узнать, какие еще сленговые выражения описывают рабочие процессы или неудачи?

(с) Gemini 3

Как вспоминал один коллега:

Подъезжает начальник к лесопилке, спрашивает сколько напилили (наполовину матом). Ему отвечают чистым матом. А он цифры в блокнот записывает!

У начальника в голове естественная нейросетка (ака нейронный ансамбль) по переводу текста в цифры - этот загиб от Василия с начале дня, с таки артикулированием - значит 5 кубовж; а такой же от Коли в пятницу после получки - всего 2 )

В армии, на стройке, в командном спорте экстремальное семантическое сжатие - бесценная вещь

Главное чтобы обучение происходило

на одном и том же корпусе текстоводних и тех же анекдотах, компаниях и ситуациях)По фене ботают

Не, текстов "на фене" открытом доступе пока мало, обучать трудно.

Ясен пень, тут требуется операционка на образах. Чего нет и вряд ли будет

Перспективный чат детектед! Сим повелеваю - внести запись в реестр самых обсуждаемых за последние 4 часа.

Работяги нагрузили полный самосвал мусора на стройке. Подходит прораб:

- Нахера дохера нахерачили?! А ну, выхерачивайте нахер!

А как быть с "бобр курва, я пердолю"

Лучше никак, а то нейросетка может галлюцинировать и классифицировать автора текста "пердолить бобра" как зоофила ...

Вовочка, ты почему отвечая за доской грязно метеришься?

Марьванна, это я симантическую компрессию использую.

Антон Переходов. 😅 Это ник?

Нет, обычная фамилия студента ).

Вот данные о работе на сайте ВШЭ

https://www.hse.ru/edu/vkr/1053304669

О, спасибо что спросили, оказывается в оригинале это

МАГИСТЕРСКАЯ ДИССЕРТАЦИЯ На тему: Эффективная передача смысловой информации через преобразование нецензурной лексики

Один мой товарищ еще короче высказывался - Люди - ... на блюде.

Трындец! Студенты ВШЭ англичанам все секреты выдадут. :))

Я в армии (по призыву) служил 86-88.

Первым делом всё чурбаньё обязательно улавливает всю матерную (обсценную) лекскику. Вот тогда можно и поговорить. Дело ведь не в том "какие слова сказал", а как именно их сказал и произнёс. Это не просто набор слов, это ещё и эмоции. Думаю, раньше в армии было тоже самое.

Я как-то в ЯрГУ с приятелями общался. Так вот у них сосед рядом (кабинет) занимался русской обсценной лексикой. Ездил по полям и весям, записывал... Так вот, они ухохатывались чуть ли не до коликов, когда он в своей коморке включал записи собранные на просторах матушки Руси?!

Материться? Да многие просто не умеют. "Бл*" через раз или "пох", или "ёпть"? Неее это не красиво. Уметь надо. И эвфемизмы не обязательны, кстати.