В последнее время, в связи с быстрым распространением и заметным улучшением качества публично доступных LMM, понятия «Искусственный Интеллект» и LLM часто используются как взаимозаменяемые. На самом деле между ними есть очень большая разница. Используя простую визуальную аналогию, мы попытаемся продемонстрировать, почему LLM не являются и никогда не будут «настоящим» интеллектом. Начнем с задач, которые решает интеллект.

Представьте, что вы отправляетесь в поход в горы и пытаетесь сориентироваться. У вас есть карта, на которой показаны контуры местности, но это лишь приблизительный контур. Вы можете видеть общую форму холмов и долин, но не можете разглядеть мелкие детали. И вы не можете разглядеть тропинки, которые не были исследованы раньше.

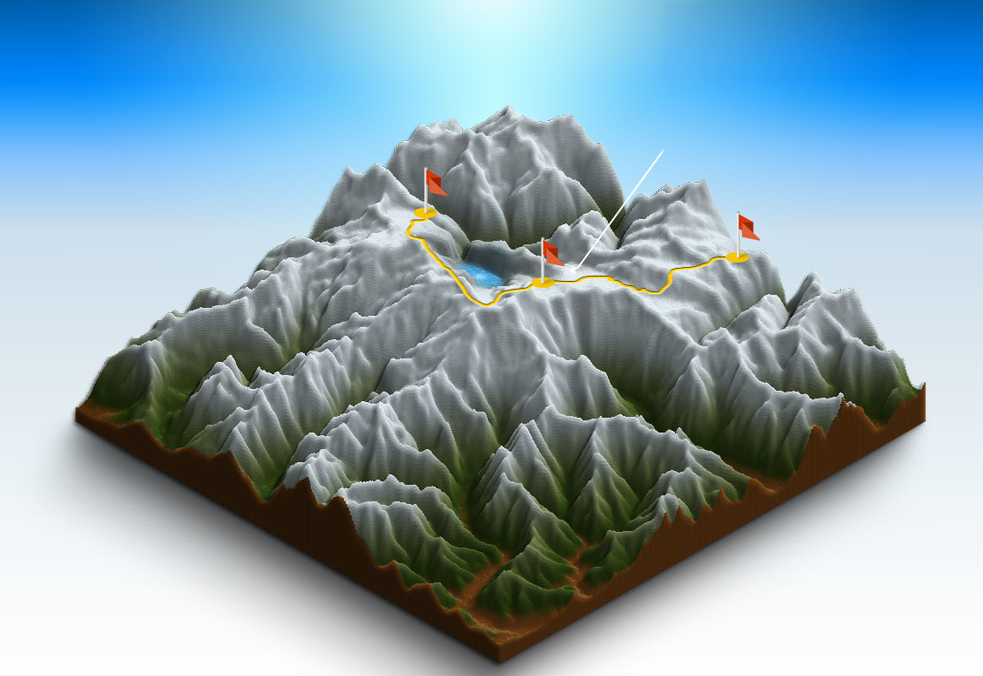

Рис.1. Упрощенная визуальная модель "реальности". Линия представляет собой путь или логическую цепочку перехода из одного состояния системы в другое (флажки).

Это в какой-то степени похоже на то, как работают Большие Языковые Модели (LLM). Они обучены обобщать огромное количество текстовых данных, и результат можно рассматривать как приблизительную контурную карту реальности. LLM может с легкостью перемещаться по этой своей карте, распознавая закономерности и взаимосвязи между словами и понятиями.

Разумеется, эта контурная карта является лишь моделью реальности, и она ограничена данными, которые были использованы для создания этой карты, самой контурной картой и даже архитектурой LLM.

LLM: Несовершенное моделирование неточной модели реальности

LLM - невероятно мощные инструменты, но они хороши лишь настолько, насколько хороши данные, на которых они были обучены, даже не учитывая, того, что они с этими данными делают. LLM могут распознавать и генерировать текст, похожий на тот, который они видели раньше, но они не могут исследовать новую территорию. Они не могут «видеть» путей, по которым еще не ходили, просто потому, что у них нет о них информации.

Это серьезное ограничение LLM, и это то, что часто упускается из виду. Мы склонны сосредотачиваться на их способности генерировать текст, похожий на то, что пишут люди, но забываем, что они работают только в рамках своих обучающих данных.

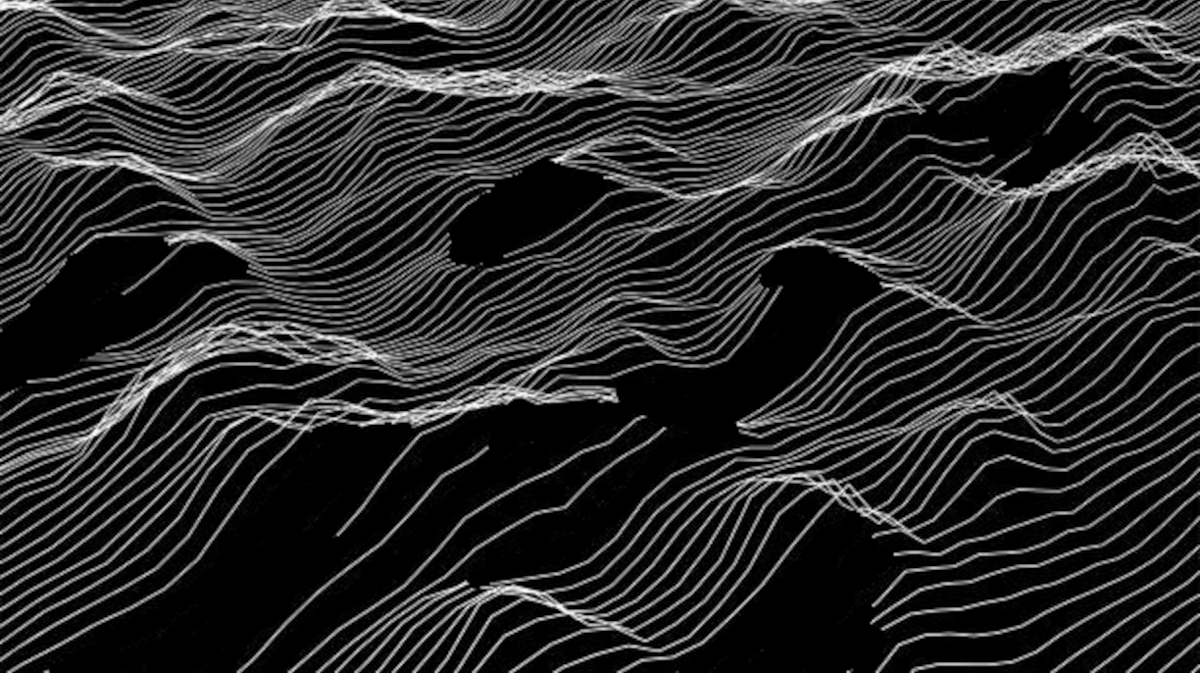

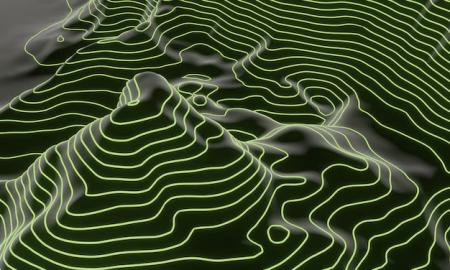

Аналогия с контурной картой

Аналогия с контурной картой - полезный способ обдумать это ограничение. Точно так же, как и контурная карта, LLM способны «видеть» только контуры реальности, а не мелкие детали. LLM могут распознавать закономерности и взаимосвязи линий сетки, но они не могут «видеть», что находится между этими линиями, или «знать» основную структуру реальности.

Рис. 1. Намеренно преувеличенный пример. Здесь "реальность" представлена в виде трехмерного ландшафта. Горные хребты могут соответствовать, например, "энергии" или ресурсам, необходимым для того, чтобы перелезть через них. Контурные линии представляют собой "цепочку размышлений" LLM (CoT) — это записанные «маршруты» в обучающих данных, в том виде, в котором они были сохранены LLM.

В примере на картинке выше, LLM может «перемещаться» только по контурным линиям, соединяющим две точки - запрос и ответ, и только если эти точки расположены строго на одной линии. Обратите внимание, что в этом примере линии не пересекаются и что есть промежутки без каких-либо линий. В данных используемых реальными LLM линии, конечно, пересекаются, что дает LLM несколько больше свободы, в том числе и то, что иногда называют "комбинационным творчеством" (combinatorial creativity). Но «дырки» никуда не исчезают, и у LLM в них доступа нет.

Что это значит для перспектив создания AGI

Аналогия с контурной картой имеет значение для выбора перспективных направлений исследования в создании искусственного общего интеллекта (AGI). Поскольку LLM ограничены перемещением по контурным линиям, то AGI необходимо будет развивать таким образом, чтобы он позволял исследовать новые территории и прокладывать пути, по которым раньше никто не ходил. LLM для этого не подходят принципиально.

Для этого необходимо разработать новые типы искусственного интеллекта, способных обучаться и рассуждать более общим и более независимым от предыдущих данных образом, вместо того, чтобы просто полагаться на распознавание образов и генерацию и быть по сути (сжатым) хранилищем знаний и поисковой системой с интерфейсом на человеческом языке.

Заключение

Аналогия с контурной картой позволяет визуализировать ограничения присущие LLM и подчеркнуть разницу между «интеллектом» (даже машинным) и по сути некой разновидностью базы данных. Это также подчеркивает сложность проблем, которые необходимо решить, а также заблуждений, которых стоит избегать при выборе направлений работ по созданию AGI.

) как текста созданного llama, так и перевода.

) как текста созданного llama, так и перевода.

Комментарии

Механистический подход. Вы лишь описали свою реальность или свое представление. Если данных(в какой либо описанной непротиворечиво смысловой системе(например изготовление печатных плат)) хватило на нарезание векторов условного кубика-рубика, далее ИИ их будет крутить как угодно, даже так как никто до этого не делал и даже не мог себе представить, но в рамках этого кубика рубика. Это больше похоже на ТРИЗ(теория решения изобретательских задач).

ну .. пусть механистический - я же закоренелый реалист, поэтому "моя" реальность действительно реальная (русская шутка)

(русская шутка)

вы,кажется, говорите о "комбинационном

интеллектетворчестве", да?. Согласен, ТРИЗ - пример такого "интеллекта", поэтому он и не работает в общем случае. Это та же контурная сетка.Кстати сам пост - это тоже пример работы "интеллекта" LLM - машина не смогла сама связать контурную карту и LLM - ей пришлось показать "новую" идею (контурные линии) и дать инструкции - т.е создать линии в буфере контекста, которые она потом соединила с известными ей линиями. Да, именно этот "интеллект" используется людьми в 99%+ случаев того, что мы понимаем под "интеллектуальной" деятельностью. К тому же, за порядка миллиона лет эволюции человека и ~ 5 000 технологического развития, сетка контуров уже найденных решений достаточно плотная в тех местах, где решения искали. Но этот "интеллект" не заполняет дыры.

дык... крутить кубик можно бессмысленно, механически перебирая все варианты, а можно

осмысленноинтеллектуальноКогда вы задаете вопрос кубик и начинает крутиться в направлении вектора вашего вопроса, при этом да, кубик существовал до вашего вопроса, его нарезали в процессе обучения

можно. Забавно, что LLM бы крутила кубик "интеллектально", но если ей дать скажем пирамидку, она бы скорее всего, не справилась (если ее не тренировали на ней).

Можно технический вопрос.. Вы имеете какое-то отношение к разработке LLM?

я ваш технический вопрос не понял. Если вы спрашиваете платит ли кто-то мне за это, включая LLM и оборудование - нет, не платит.

Просто когда люди начинают критиковать что-то, в том числе современные технологии, хочется понимать, насколько эти люди близки к той теме, о которой говорят.

можно я на это просто смайлик поставлю?

я за свою жизнь был "близок" к очень разным темам в очень разных областях. В чем я уверен, это в том, что способность делать что-то полезное или интересное не является достаточным условием для получения официальной должности и титулов. И более того - часто не является необходимым.

Спросил у DS относительно вашего скепсиса. Он пишет о гибридных системах. У него есть план.. и он его придерживается )

Но я здесь скорее про контурную сетку как удобную визуализацию пределов возможностей LLM, чем ответа на вопрос "что делать?". Ниже первые пара страниц очень чернового черновика откуда была выдрана идея с контурной картой (Alex Zweistein is a Russian Joke)

Развитие технологий должно проследовать какие-то цели. Иначе говоря, все начинается с философии..

Вот и хотелось бы понять: с какой целью разработчики стремятся к созданию AGI?

Дело в том, что не будет уровня развития при котором ИИ будет равен человеку потенциалу. В случае достижения результата возникнет система превосходящая человека по когнитивным возможностям. Более того, мы даже не сможем этот момент своевременно зафиксировать.. в силу своих собственных когнитивных ограничений.

я с вами согласен.

С какой целью? - ну да ... это надо (бы) спросить того кто эту цель поставил. Для себя я держу удобную картинку, что цель запрограмирована где-то в ДНК, и скорее всего направлена куда-то далеко - к освоению пространственной шкалы и использования потока энергии характерных для окружающей "среды" - космоса. Мы где-то около нуля, и только начинаем как бы шевелиться, и нам в нашем виде эти масштабы не доступны. Нас заменят на что-то. Но это не точно (но конкретно LLM бояться нужно не больше, чем необычно умного человека, ну или убийственно эффективную базу данных.)

(но конкретно LLM бояться нужно не больше, чем необычно умного человека, ну или убийственно эффективную базу данных.)

А модели этой хватит 24 гига видеопамяти чтобы обучать с ней лоры?

Эта конкретная модель Llama3.2-vision11B-instruct-q8 у меня работает на уже реликтовой RTX 2070 Ti со всего 8Gb, и она здесь почти случайно в том смысле, что для конкретно этого запроса ее текст был ближе к тому, что я хотел.

ЗЫ На самом деле у меня появилась идея - вот эта аналогия с контурной сеткой и тем, что там в комменте в свертке, и я решил проверить ее на практике - можно ли заставить LLM сгенерировать эту же идею "самостоятельно". Мне это не удалось. Я прогнал одни и те же запросы через .. 7 моделей от 8B до 70B, с различными квантизациями и соответственно размерами от 6Gb да 28GB на той же 2070 видеокарте в ollama CLI. Скорость разумеется разная, но вполне терпимая. У вас с 24 Gb будет наверное в 3 раза быстрее (c LoRA будет зависеть от того на чем тренировать)

Есть мнение , что шум это не про точность приборов и масштабы, а про то, что "так реальность для нас работает". Арбузов называет это шумом с фронтира познавательной способности и явлений.

.. это ответ на незаданный вопрос "как сделать лучше", и вы про то, что шум может перекрывать линии контуров (в этой модели)? это не "спасет" LLM - и там уже есть регулируемые параметры шума. Двигаться в неизвестные области - да, только случайным образом, как всегда и было. Тогда будет много бредовой генерации.

Не более , чем у гуманитарного Арбузова.

Как "много" и насколько функционально приемлемой генерации? И какой масштаб для чего нужен?

Если взять соотношение "исследованного", контурно обозначенного не будут ли это те же эмпирические Парето «20% усилий дают 80 % результата, а остальные 80 % усилий — 20 % результата»? И где то, какой то "резерв" на вариативность данных - на стохастическое - "пыль, поднятая копытами , которая скрывает явление, до момента, как оно станет явлением при столкновении с познавательной способностью"? И это фатально в "голове" - резерв на фоновые процессы , на скрытые данные, "стохастическое".

Вот вот. А откуда знать - где и сколько подрезать и на каком масштабе? Генерируя толпу "тысячепалую" , подсчитывается ли пресловутое количество пальцев "по головам"? Вряд ли же.

PS

Вряд ли же .. или информация о конвенциональных "2х5 пальцев га 1 голову" тоже участвует?

И здесь вероятности динамики рельефа - где то осыпалось, где то нанесло, где то осыпается, может посыпаться и засыпать . Оно то и для человеков нестатично

что-то в ваших комментах есть, но я не уверен что именно..

может быть общество LLM с "царем", кабинетом министров, армией, полицией, рабочими - ну и сумашедшими. Последние будут периодически сообщать, что в центре солнечной системы солнце, скорость света не зависит от скорости источника, частицы не частицы, а как бы волны, но не всегда и тп ... Все в примерной пропорции к среднему по планете у людей - 1 такой сумашедщий на несколько миллионов рабочих (а то кто их кормить киловаттами будет?). И дальше все как положено - войны, прогресс, полет на Марс (наконец) и тп Как вам такое? Я конечно шучу, но полагаю, что это не для LLM,. LLM - это просто сложные базы данных накопленного опыта. Они даже не интерполируют. Они могут быть бесценным инструментом, но только в руках кого-то (или чего-то) еще.

Что то про критерии "округления" и "обрезки шума", приоритеты, выбираемые при масштабировании.

Всё опять упирается в лабильность человеческого понятия "интеллект" .