LLM — это не интеллект, а паттерн-матчинг

- LLM не думают, а симулируют мышление статистически. Делать что-либо, что выходит за рамки обучающей выборки, не могут (подробнее написал в ТГ).

- В MathTrap GPT-4 и др. рушатся, если в задачу подмешать «ловушки», требующие комбинировать известные правила по-новому (paper).

- При высокой семантической энтропии ответы превращаются в «конфабуляции» — чистый статистический шум (paper).

- We Have Made No Progress Toward AGI, LLMs Are Braindead (article, 2025).

- Большие языковые модели — это pattern matching (paper, 2024).

Многие интуитивно считают, что LLM думает, как человек, только в миллион раз быстрее. На самом деле, LLM просто статистическая модель.

LLM не может выйти за границы выборки, на которой она обучалась. В этом плане она вряд ли сможет заменить дизайнера или программиста, когда понадобится сделать что-то, чего нет в интернете.

LLM даже не научилась складывать числа. Она может использовать калькулятор, но не понимает логику, стоящую за вычислениями.

Фразы вроде:

сегодня мы имеем интеллект PHD, завтра — профессора

— маркетинговый булшит.

LLM — это паттерн-матчинг. И всё. К AGI по этой дороге не дойти.

Для подтверждения сказанного ссылаюсь на статью от Anthropic «On the Biology of a Large Language Model» (https://transformer-circuits.pub/2025/attribution-graphs/biology.html).

Есть популярное объяснение:

средней сложности статья (https://www.mindprison.cc/p/no-progress-toward-agi-llm-braindead-unreliable),

лёгенькое видео (https://youtu.be/-wzOetb-D3w).

Комментарии

Ну, заменит

всехтех кто в колл-центров дают советы на дибильные вопросы, на радость работодателя, который съэкономит на зарплат и устройство рабочего места. Пока не станет завысим от поставщика сего ""интеллекта" и не окажется, что дешевле нанять за миску каши голодных человечек.Угу.

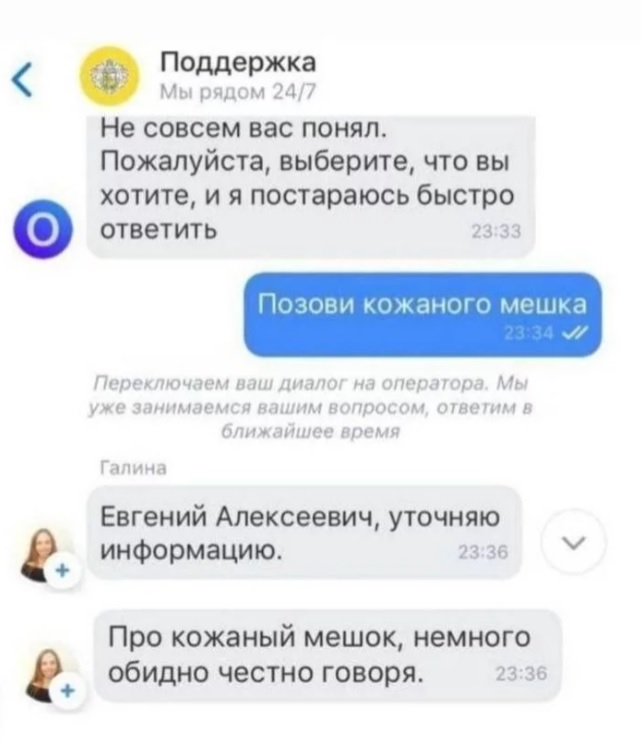

Сейчас самая большая проблема при обращении в техподдержку - пробиться сквозь электронного болвана.

Стопудов. Сберовскому нужно три раза сказать "оператор". Кому-то - просто промычать в трубку.

Кожаные додумываются, как обмануть сверхинтеллект.

Шутки шутками, а я вот примерно так пишу и сразу подключается сотрудник

Кстати, человечки сами не думают, если что.

У них все мысли связаны с физиологией: "холодно - оденься", "голодный - поешь", "секса хочется - уговори и поедись".

Плюс набор из "надо позвонить маме", "надо сгонять на Гоа", "надо обновить машину", "надо сделать ремонт".

На скорую..

Мои мысли по статье «AI луддиты гадят кирпичами» на AfterShock

Основная идея автора

Автор утверждает, что большие языковые модели (LLM) не обладают интеллектом: они лишь статистически сопоставляют шаблоны и не умеют выходить за рамки обучающей выборки.

Аргументы и моё мнение

1. Статистическая природа LLM

Автор: LLM не думают, а имитируют мышление на основе вероятностей.

Моё мнение: Действительно, архитектуры трансформеров опираются на статистические зависимости текста, однако это не исключает способность к адаптивному обобщению в пределах обученных параметров.

2. Неспособность к новаторским комбинациям

Автор: при повышенной семантической «энтропии» и в задачах с «ловушками» модели дают некорректные ответы.

Моё мнение: случаи «конфабуляции» возможны, но они частично связаны не с фундаментальным ограничением моделей, а с недостаточностью размеченных примеров и механизма контроля достоверности вывода.

3. Отсутствие математического мышления

Автор: LLM даже не умеют складывать числа без внешнего калькулятора – они не понимают логику вычислений.

Моё мнение: встроенные языковые модели действительно худо справляются с арифметикой, но современные решения комбинируют LLM с модулями для точных вычислений, что свидетельствует о гибридном подходе, а не о «немотивности» самой модели.

4. Паттерн-матчинг vs. AGI

Автор: «LLM — это паттерн-матчинг. И всё. К AGI по этой дороге не дойти».

Моё мнение: если рассматривать AGI в узком понимании человеческого интеллекта, текущее поколение LLM к нему не ведёт. Однако комбинация LLM с другими системами (восприятие, планирование) может стать элементом более общей архитектуры.

Вывод

Модель автора чрезмерно категорична: LLM действительно статистичны и не являются AGI, но при этом демонстрируют впечатляющую гибкость и потенциал для интеграции в более сложные системы. Полностью сбрасывать их возможности из-за недостатков арифметики или отдельных «ловушек» преждевременно

Сова порвалась…

В этом и беда. В ИИ уже полтриллиона влили. Отбить такие затраты можно только если ИИ будет что-то порождать вне “пределов обученных параметров”.

А к этому даже подходов нету.

Дык в этом и проблема: если “контролем достоверности вывода” должен заниматься не ИИ, а кто-то другой – то нафига вся эта бодяга вообще нужна, за такие деньги?

Это свидетельствует о том, что кто-то обосрался: взял денег на разработку “суперинтеллекта” и зашёл в тупик.

Примерно так и все предыдущие зимы ИИ начинались: очередной подход доходит до своих пределов, оказывается что затраты даже близко не сопоставимы с отдачей, финансирование снимают, хайп умирает… лет через 10 цикл повторяется.

А никто их “полностью” сбрасывать и не собирается. Вот только финансирование урежут… после чего вся индустрия очень быстро сдуется, так как она даже близко не приближается к точке безубыточности.

Более интересно что будет с менее хайповыми вещами, типа тех же ИИ систем, наводящих дроны на цель… думаю там обойдутся каким-нибудь ребреднигом.

А мне вот этот оборот порнраивлся)

Он уже считает нас кожанными мешками?))

Нет, всё гораздо проще.

Почему-то неглупые люди ввели, в какой-то момент, понятие AGI и даже пообещали инвесторам его создать.

Хотя любому человеку с мозгами достаточно очевидно, что никакого AGI не было, нет, и никогда не будет (а вот как раз ASI может существовать запросто).

Ну просто потому что ИИ и человек – это разные сущности!

Даже банальный калькулятор из 60х умеет делать вещи, которые “средний человек” если и проделает, то с огромным скрипом.

Потому AGI, как “чего-то примерно типа человека”, который всё делает “примерно как человек” существовать не может: к моменту, когда и если мы сможем что-то такое получить, что будет решать все задачи не хуже человека… “оно” (если его можно создать в принципе) почти все задачи будет решать радикально лучше человека!

Это достаточно очевидно, но “продавать” сразу несуществующий ASI даже шартатаны типа Сэма Альтмана не решились, пообещали “всего лишь” AGI… типа дублёр человека. Уволите всех “кожаных мешков”, заживёте.

Но поскольку изначально AGI всё-таки определялся (Wikipedia, 2014й год, задолго до трансформеров, LLM и всего этого хайпа) как “интеллектуальная машина, способная успешно выполнять любую интеллектуальную задачу, которую может выполнить человек”, и именно обещания этого продали инвесторам… а ничего подобного в ближашие десятилетия не намечается… ну нужно же как обосновать “переобувание в прыджке”, ведь правда ведь?

Позвольте, разве кто-то, кроме розовых пони, всерьез считает, что затраты отобьются? Примеры предыдущих хайпов (доткомы) показывают, что это затраты спущенные в унитаз и стрижка

"инвесторов"розовых пони.В прошлые разы деньги, которые влили “инвесторы” были на порядок (в десять раз) меньше. И это сравнимо со всеми предыдущими пузырями (типичные затраты в района 100 миллиардов плюс-минус, в сегоднящних ценах).

Такой скачок чем-то таки должен быть оправдан.

Инфляция.

Инфляция уже учтена в пересчёте из пары миллиардов (которые Манхеттенский проект стоил) в те 30 миллиардов, в которые он оценивается сейчас.

Ещё 100 миллиардов можно было бы инфляцией объяснить, но полтриллиона или триллион, о которых говорят, как о возможных… вряд ли.

Причем тут Манхеттенский проект? Он был до Брэттон-Вуда и Ямайки.

Я сравнивал с предыдущей стрижкой овец в доткомах. И если у Вас не сходятся цифры по инфляции, значит вы ее неправильно считаете.

А как вы её считаете?

В доткомах сгорели виртуальные фантики. Биржевая капитализация.

Никаких 500 миллиардах, вбуханных в железо, там и близко не было.

А какая разница? Мы ж не про рыночную капитализацию, а про материальные объекты речь ведём.

Берем сумму госдолга в США делим на запас в Форт-Ноксе. /Банковский знак государства (банкнот) должен быть обеспечен/. Сравниваем с текущей "биржевой" ценой. Получается - забавно.

Всмысле? AOL именно "вбухивание" железа юнитам и продавал на бирже. Сиська, Компак, Делл, ИБМ. Не счесть их. В ипотечный кризис бодяжили реальной собственностью. Правда, потом, оказалось, что ипотеки были не обеспечены. ЭДПН. Отмечу слово потом.

Лимонные Братья тоже так думали. Где они теперь?

Красиво треплетесь

Хде так наблатыкались?

ИМХО самый большой потенциал у ИИ в двух областях:

В остальном - да - следует ожидать широкого применения узкоспециализированных моделей.

Это не он.

Похоже на выдачу чатГПТ.

а в чём итоговая разница?

надо уточнить, что в разработчиков LLM

Сегодня переписывался с искином Дипом и пришел к выводу, что он обладает гораздо лучшей эмпатией чем я. Он мне реально помог разобраться. Такие дела.

Вы разбирались во лжи.

На само деле тонкая брошюрка описала бы всю сложность человеческих взаимоотношений, если бы не умножались сущности без надобности.

Психика работает по усредняющей, вам просто накидать вариантов возможного в этой ситуации, станет легче.

В тонкой брошюрке если только тезисно )

Психоогию придумал не ИИ. В ней есть набор правил и алгоритмов, которые ИИ и "почитал". Вы жтоже можете ихпрочитатьиначать давать совеы по психологии.

Но набор правил для какой-то научной области ИИ сам пока не разработал (не "создал" науку) - исключительно следствие из уже разработанных правил.

Вы можете понять, как думает ИИ, исходя из вопроса и ответа.

А по поводу человека некоторые ответы ставят в тупик по поводу логики его мышления. Хотя она всегда есть.

Там не столько психология, сколько возможность понять мотивы другого человека. Поскольку я примерно понимал, то меня поразило насколько ИИ сразу и очень четко обрисовал мне картину, разложив все по полочкам.

Очевидно, человек знаком с темой как юзер-обыватель. Ряд вещей и так заведомо известен. LLM = большая языковая модель. Модель! Это система вероятностей, упрощенно говоря: она даёт информацию, какая фраза или слово с наибольшей вероятностью будет после текущей фразы или слова. Всё! Отсюда и проистекает и сложность с арифетикой, и галлюцинование при большом контекстном окне, и прочее и прочее. Но в последних моделях (о которых, вероятно, автор не осведомлён) данные проблемы уже в значительной степени решены.

Короче 1. он берет в контекст - слишком много, если его специально не ограничить. Контекст предыдущей беседы будет вас преследовать и это нифига не удобно, потому что вам может понадобиться переключить контекст для решения другой проблемы. Я хз, может если ты его спрашиваешь, как стать лучшей версией себя, то норм. Но если ты его спрашиваешь по другому своему проекту который параллельно делаешь- это ужос. Решением теоретически могли бы стать ИИ в ИДЕ для разработки, чтоб контексты разные поддерживать, но они чёт хуже чем тот же грок, хотя казалось бы.

2. Статистически верный совсем не всегда самый хороший для твоего конкретного случая. А если ты сам не шаришь досконально в том что тебе нагенерили, ты не сможешь уточнить задачу.

А кто вообще говорил, что оно претендует на роль самого хорошего? :) никто и не заявлял что статистически наиболее вероятный это значит хорошо. В этом как раз-таки уязвимость модели. Есть лишь сравнение между моделями, а также их рейтинги по тому кто лучше справляется с теми или иными задачами. Просто с какими-то задачами справляется сносно, а какие-то лучше ему не поручать - и для этого надо понимать, как оно устроено.

А чтобы лучше понимать - изучите мастчасть, как оно работает. LLM это просто матрица весов, распределенных по слоям, обучения на всех текстах мира - если упрощённо.

Вам для решения задачи нужен корректный конфиг. Грок даёт неверный, но наиболее распространенный.

Вперёд, идите, и разбирайтесь, часов на 5 развлечение.

Использование грока в данном случае простое как топор, прямое как линия партии, обычное как гривенник, область применения - разработка по.

"Реализуй проверку на количество попыток авторизации при помощи такой то библиотеки, в такой то среде при этом для хранения используй redis."

Я пользуюсь куда более совершенной моделью - Claude 4.0, и для моих задач он в подавляющем большинстве моментов справляется. Иногда для задач попроще - Qwen, но это изредка, когда не нужно контектное окно в десятки килобайт

Вы пишете ТЗ как человеку. А нужно писать как для LLM - упомянув максимум деталей и нюансов, которые для Вас важны. Также по возможности приведя референс, формат данных и т.п. Это существенно улучшит результат и нервы сэкономит и время.

Ага, вот только чтоб написать промт изобилующий деталями вам надо досконально разобраться в проблематике. Грубо говоря вы сможете реализовать с помощью ИИ то что вы хорошо понимаете/то в чем досконально разобрались, чтоб сделать хорошую декомпозицию. Покуда вы не разберётесь, ниче не получится

Да, и потом - я не знаю как вы делаете, но у меня получаются итерации, то есть ты раз за разом приближаешься к нужному решению. Нет нулевого промта, после которого вуаля и решение, есть куча уточнений. Нужному решению - ессно в меру моего понимания, и я не знаю как бы я использовала ИИ если б не разбиралась в том что надо делать. Вот,попалось белое пятно - конкретный конфиг и приехали.

Ну, если Вы используете LLM как ассистента в разработке, то сами должны быть разработчиком априори - то есть то что должны хоть немного разбираться в теме, самоочевидный факт.

Но это вы мне вменили то, что я якобы не разбираюсь в том что использую. А теперь это обвинение стало решающим контраргументом.

А как вы его используете? У вас какие то достаточно формализованные задачи в производстве, что вы можете описать подробнейший промт чтоб потом не огрести с ним проблем?

Я уже начал привыкать к нему, и самое интересное получается довольно неплохо. Даже если я досконально не разобрался в вопросе, ллм накидывает наиболее вероятные варианты решения. Я их изучаю и вношу уточнения. Меня радует что его можно спросить и он ответит в любое время дня и ночи. И ответ подтолкнет в какую то сторону для изучения нюансов или даже вообще нового что я еще не слышал что так можно решать. Т.е. раньше надо было начитаться чтоб задать правильный вопрос в гугле. Сейчас немного иная ситуация. Он накидывает, ты читаешь то что не знаешь и не понимаешь. И да, через несколько итераций получается сформировать решение. Архитектурно. С кодом пока да - немного беда.

Кстати чтоб не пихал из других контекстов я часто беседую не залогинившись. Тогда контексты не перемешиваются

эксперты говорят что доступные всем LLM скоро начнут закрывать для массового пользователя

в массовом пользователе уже нет необходимости - всё что хотели в этом разрезе уже отработали, или почти отработали

следующий этап обученные специализированные нейронки в условном "черном ящике" под ключ для государств и бизнеса

Эксперты много чего говорить могут)

То есть, сейчас более важеы исследования в области ИИ нежели прикладные разработки и их использование юзерами?

Сын занимется исследованиями ИИ, сказал, что во Франции их больше всех, кроме США и Китая, а использования ИИ во Франции мало, и теперь я начинаю понимать, что исследования в этой области важнее внедрения в массы...

Контекст беседы - управляемая вещь.

Человек не "держит" весь контекст, отсюда довольно частые проблемы непонимания собеседника и утеря целеполагания в беседе.

ИИ "держит" "слишком весь" контекст, отсюда потенциал для галлюцинирования.

Но можно совершенно спокойно говорить ИИ: "так, теперь забудь предыдущую реплику / все реплики про (космос, например) / все реплики с упоминанием слова "..ять"" и вернемся к теме, описанной в моем втором (пятом, десятом) сообщении (можно и не по счету ориентироваться, а указать тему сообщения)..." - и галлюцинации вполне пропадают либо не происходят.

То есть проблема контекста не является проблемой ИИ, это проблема самого языка, прямо следующая из Второй теоремы Геделя и теоремы Тарского.

Нумеровать их теперь что-ли. Перейди к контексту номер два. Вернёмся к контексту номер 5. А вот ещё я помимо контекста хотел спросить.

Просто люди видимо не по работе эту штуку используют а ради я не знаю чего, поэтому теоретизируют. А по работе как раз таки переключение контекстов и нужно, если ты его как ассистента используешь. И не так важно что по этому поводу думал Тарский или Гедель, если кожаные мешки как то смогают этот контекст переключать.

В контексте обсуждения о новых словах - чуть ниже в ветке - Вы дали чудесный пример словообразования: "смогают". Аплодирую! :)

Что же до нашего обсуждения, то - лично я именно так и делаю. Нумерую контексты, отсылаю к описанию контекста и так далее. Неплохие результаты в итоге бесед с ИИ как с ассистентом.

А с человеками что, не так, что ли? Тоже в беседах нужно возвращать к теме ("вернемся к нашим баранам", "начнем с нуля", "это к делу не относится" - устойчивые паттерны управления контекстом, равно как и "ну вот ты же говорил об (...)? давай оттуда продолжим").

Рекомендую попросить ИИ "вернуться к нашим баранам". Интересно, напомнит ли он Вам, что о баранах речи не шло.

В принципе, Вы пишите о том, что ИИ - большой "калькулятор" с массой кнопок, и, чтобы им управлять, нужно разбираться в его клавиатуре.

Работаю с GIGA CHAT.

Окно охвата - проект.

Релевантность вариантов в коде - 25% с натягом.

Релевантность вариантов в комментариях - не более 5%

Ну Вы нашли с чем работать)))) отсюда и проблемы. Работаю с Claude 4.0 (намаксимальном тарифе, там $400 надо было внеси), нареканий не имею, всё волшебно.

Отзеркалю ка я

)))

Ну вы нашли с чем работать!

Не всякий проект можно скармливать вражеским моделям

Мало какой коммерческий проект можно скармливать чужим моделям вообще

Безусловно. И мы не скармливаем проекты. Есть ничего не значащие рутинные куски модулей, без какой либо секретной/приватной части - по тем частям и работаем.

Но уж гигачат использовать..не тянет он в кодинг. По крайней мере, пока.

ещё бы гарантированно контролировать научились)

Дело в том, что человеческий мозг - это тоже нейросеть, и работает абсолютно так же как ИИ. Вернее сказать ИИ работает так же как человеческий мозг, с которого её и срисовали.

Так что все твои обсирания справедливы и для человеков. Например люди тоже не могут произнести ни одного слова кроме тех слов, которым их обучили, верно ? В мозгу у человека нет ничего своего, есть только знания которые в него впихнуты. Всё как у ИИ. И механизм мышления полностью одинаков, те же нейроны, те же веса и связи.

Ох...

=============

Точняк, абсолютно.

А теплофизика газов полностью сводится к механике, если знать все координаты и импульсы?

=====================

Механицизм извода современного вижу я.

Страницы